随着 AI 技术的发展,无中生有这件事对于大家来说,已经越来越容易了。

简单一点的,就像很多人手机里都有的 AI 美颜一样。

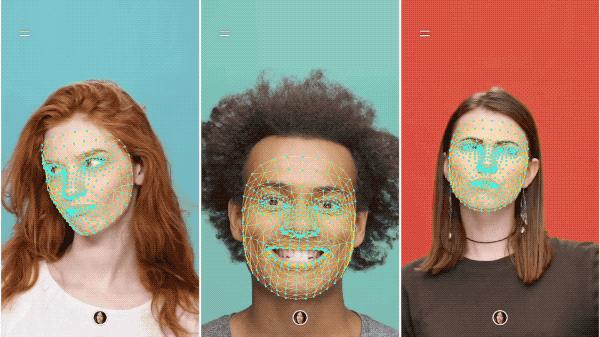

通过人脸检测,自动识别脸部特征点,然后通过 AI 化妆、添加滤镜,达到锦上添花的效果。

机哥相信这些玩法,大家都已经非常熟悉。

但是嚯,AI 能做的其实远远不止这些。

划重点,它还能够通过算法自动更换画面里的元素。

什么意思呢?

其实这事说起来并不难理解,就是类似大家耳熟能详的抠图技术。

只不过在 AI 的加持之下,这一切都可以通过程序自动完成,而不需要像以往一样,在电脑前一点一点地精细处理。

例如大家熟悉的 AI 换脸。

机哥之前给机友们介绍过,B 站上就有很多类似的视频,像是把吴彦祖的脸换到苏大强的身上。

讲真,的确是毫无违和。

后来的事情,大家也知道啦。

这项技术被不少人用在歪路子上,就是将别人的脸换在了 xx 视频上搞黄色,包括大家熟悉的明星。

于是各大平台便纷纷开始,扼制这种滥用 AI 进行非自愿换脸的行为。

不过万万没想到…最近类似的 AI 搞黄色软件卷土重来。

机哥今天想说的是,就是另外一款通过 AI 技术,实现一键脱掉衣服效果的软件。

机友们可能对这个 AI 程序不太了解,机哥抱着普及知识的心态,先简单给大家介绍一下。

这个程序基于加州大学伯克利分校研究者开发的开源算法 pix2pix 创建,使用 1 万张 xx 图片加以训练。

只要上传特定的照片,程序就能借助神经网络技术,分辨出照片的特征点。

然后,这个程序可以将衣服覆盖的身体部位,自动替换成毫无遮掩的效果,一张足以骗过大多数人的私密照就此诞生。

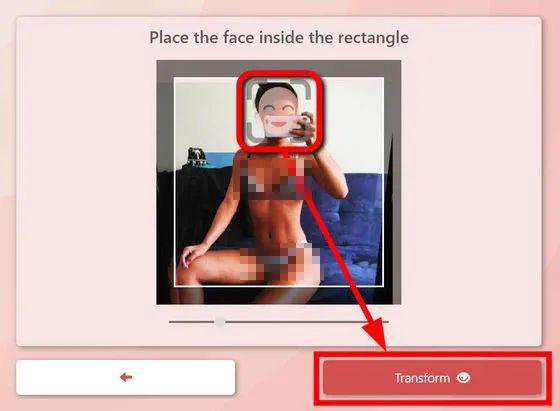

有勇敢的国外用户,使用自己的照片对这个程序进行了测试。

这个小姐姐上传了一张自己身穿泳衣的照片。虽然照片里的她露出了自己的身材,但相对来说还是比较健康的穿着。

但经过程序这么一处理,不仅小姐姐照片上的衣服不见了,程序还给她换上原本不属于她的身体部位。

从细节上看,处理效果非常逼真。比起以往移花接木的 Photoshop 假照片,简直是能够以假乱真。

虽然这个程序只有在照片里的人物穿着比较清凉的时候,才能达到这种效果,但情况还是一下子就变得一发不可收拾。

为啥呢?

包括明星在内的很多用户,都曾经在社交平台上分享过相同类型的照片,甚至有一部分已经被有心人士做成 xx 图片,在互联网上开始流传。

即便这些照片是假的,但还是一定程度上对她们造成巨大的影响。

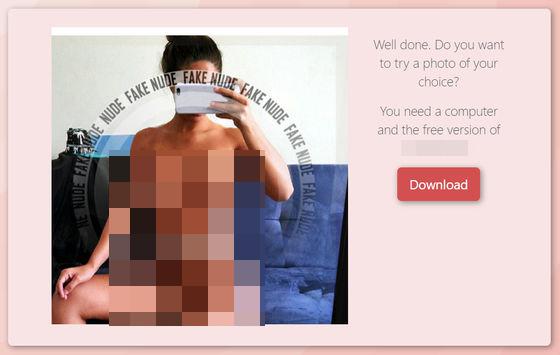

于是,在察觉到被滥用之后,开发者很快就宣布关闭这个网站及程序。

(开发者在社交媒体宣布关停)

但是别忘了,互联网并没有秘密。

由于这个程序的开发者曾经将代码,上传到开源网站,所以犯罪分子很快就将这个程序作为他们的作案工具。

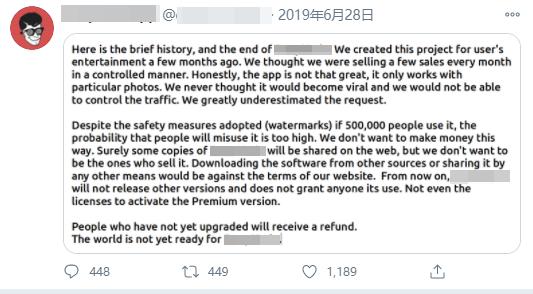

有技术研究人员通过调查表示,这个程序现在已经被内置在国外某个 App 上。

(媒体揭露这个 App 当中的程序运作)

按照技术人员的说法,在这个 App 当中,只要加入特定的群组,就能进行一键脱衣。

目前,已经有超过 68 万名女性用户的照片,被上传到这个 App 上,并且在未经其知情或同意的情况下,变成那种模拟 * 体照片。

而这些照片,还在某些群组当中流传。

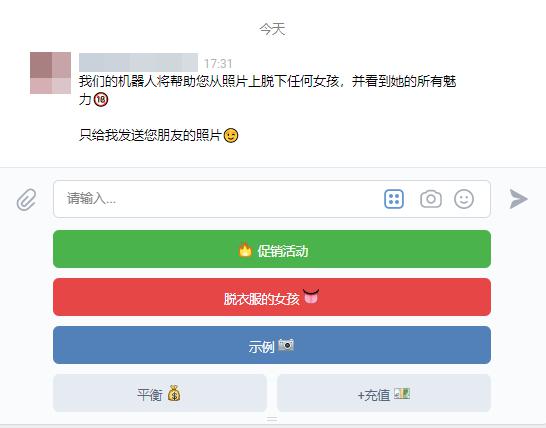

为了一探究竟,机哥下载了这个 App,为大家亲身体验下这个卷土重来的功能。

费了一番功夫,机哥终于加进去几个类似群组。

在这个群组当中,几乎所有的消息都是:

使用这个程序制造出来的假照片。

仔细看还能发现,几乎每一张照片,都吸引了几千人的观看。

机哥瞄了一眼,这些示范的照片除了专业的模特泳装照片之外,还有从别人社交网络上抓取的自拍照。

试想一下,如果碰巧在这里看到熟人的 * 体照,虽然是 AI 制造出来的假照片,那也是相当尴尬。

那么,这些假 * 体照是怎么制作出来的呢?

这些照片的下方,有链接能直接跳转到某个小程序。

在这里,开发者甚至还会亲切地帮用户指引,告诉用户哪些照片才能获得更好的 AI 脱衣效果。

按照系统的指示,只要发送合格的照片,就能获得相应的假 * 体照。

于是机哥抱着帮大家揭开这个程序真面目的心情尝试了一下,发现……这居然还是收费的。

根据成片的规格,还有不一样的收费,从人民币 4 元到 100 元不等。

而付款之后,用户就将在对话框中收到这张假 * 体照。

机哥体验了几个群组下来,大概都是这样的操作。

有的开发者还会设置关键字,确定你的年龄是否达到可以浏览的程度,还挺贴心。

不过讽刺的是,根据技术研究人员的调查报告显示,这里面的部分受害者,本身就是未成年人。

按照调查人员的说法,甚至有部分群组靠 ” 未成年人 ” 的噱头,获得不少收入。

这并不是这个 AI 程序第一次被用到犯罪活动中。

在另外一个国外的社交平台上,这个脱衣程序也同样泛滥。机哥随手一搜,就发现大量类似的内容。

看看这个文案,写得更加露骨。

在这些广告里,他们还直接引导用户发送朋友或同学的照片。

可以说是非常过分啦。

(忽略渣渣翻译)

老规矩,机哥尝试了一下。

这些社交平台上的一键脱衣程序,跟上面那些群组一样,都是通过这种方式获得非法收入的。

其实,更早之前的社交软件当中,就出现过类似的诈骗行为。

以往,犯罪分子会诱导用户发送自己的真 * 体照,从而进行勒索;但通过这个程序,犯罪分子只需要得到一张日常的照片,就能开始犯罪行为。

不仅如此,犯罪分子还能通过木马获取用户的通讯录,并且会用这些假照片,对通讯录当中的亲友进行勒索。

这么一来,身边毫不知情的人就会出于阻止 * 体照传播的目的,想犯罪分子支付所谓的 ” 赎金 “。

不得不说,就这样一个 AI 程序,可谓是闹得人心惶惶。

甚至有一些女性用户已经开始,有意减少在社交平台上发照片的频率。

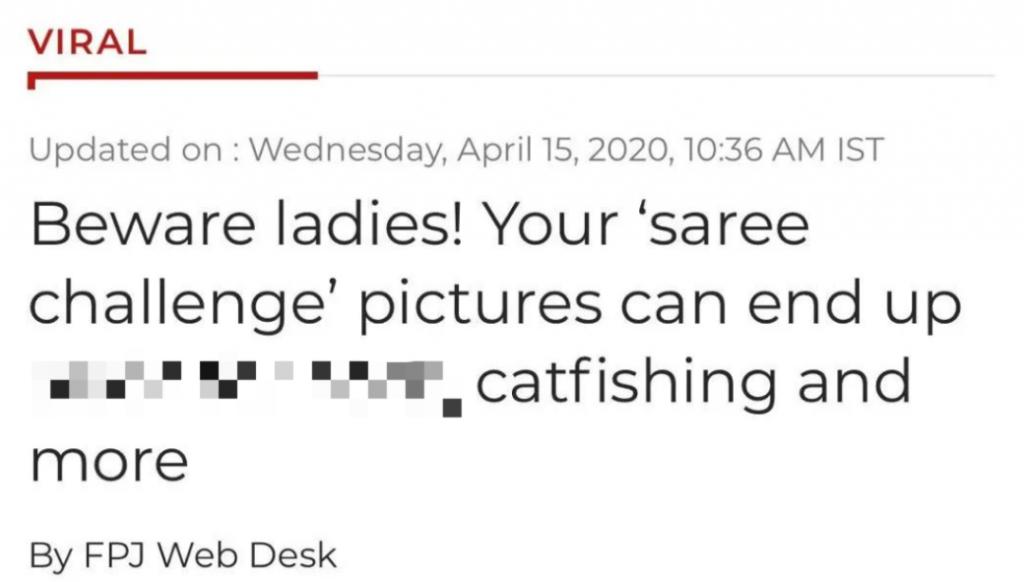

就连前不久印度的互联网站上网友发起的 ” 纱丽挑战 “,都被媒体警告可能会有风险。

按照媒体的说法,这些女孩是身上的纱丽在,在一键脱衣程序面前,简直不值一提。

而且,这个挑战活动还涉及个人隐私泄露。

一旦在挑战中艾特自己的好友,那么就相当于为犯罪分子提供勒索对象。

潘多拉魔盒被打开,那就不是那么容易就可以关上的。

特别是各种各样的 AI 技术,被滥用的后果,简直是细思恐极。

当然,各种从 AI 技术衍生出来的犯罪行为,该打击还是得打击。

但更重要的是,如何从根本上解决这个问题。

面对这个一键脱衣程序,目前还没有一个完美的方法,大概只能寄希望于其他开发者,能开发出一套让照片无法被 AI 识别的方法啦。

机哥还是那句老话:

求求你们别再用这些 AI 技术搞黄色了啊……

老徐小屋

老徐小屋